OpenAI breidt zijn interne veiligheidsprocessen uit om de dreiging van schadelijke AI af te weren. Een nieuwe ‘veiligheidsadviesgroep’ zal boven de technische groups zitten en aanbevelingen doen aan het leiderschap, en het bestuur heeft vetorecht gekregen – of het daar daadwerkelijk gebruik van zal maken is natuurlijk een geheel andere vraag.

Normaal gesproken behoeven de ins en outs van dit soort beleid geen berichtgeving, omdat het in de praktijk neerkomt op veel bijeenkomsten achter gesloten deuren met obscure functies en verantwoordelijkheidsstromen waarvan buitenstaanders zelden op de hoogte zullen zijn. Hoewel dat in dit geval waarschijnlijk ook het geval is, is de recente leiderschapsfracas en de zich ontwikkelende discussie over AI-risico’s rechtvaardigen dat we eens kijken naar de manier waarop ‘s werelds toonaangevende AI-ontwikkelingsbedrijf veiligheidsoverwegingen benadert.

In een nieuw doc En blogpostbespreekt OpenAI hun bijgewerkte ‘Preparedness Framework’, waarvan je denkt dat het een beetje is aangepast na de opschudding in november waarbij de twee meest ‘decelerationistische’ leden van het bestuur zijn verwijderd: Ilya Sutskever (nog steeds bij het bedrijf in een enigszins gewijzigde rol) en Helen Toner (helemaal verdwenen).

Het belangrijkste doel van de replace lijkt te zijn om een duidelijk pad te tonen voor het identificeren, analyseren en beslissen wat te doen met de ‘catastrofale’ risico’s die inherent zijn aan de modellen die ze ontwikkelen. Zoals zij het definiëren:

Met catastrofaal risico bedoelen we elk risico dat zou kunnen resulteren in honderden miljarden {dollars} aan economische schade of zou kunnen leiden tot ernstig letsel of de dood van veel individuen – dit omvat, maar is niet beperkt tot, existentiële risico’s.

(Existentieel risico is het sort ‘opkomst van de machines’.)

In-productiemodellen worden bestuurd door een ‘veiligheidssystemen’-team; dit is bijvoorbeeld voor systematisch misbruik van ChatGPT dat kan worden beperkt met API-beperkingen of afstemming. Frontiermodellen in ontwikkeling krijgen het ‘paraatheidsteam’, dat risico’s probeert te identificeren en te kwantificeren voordat het mannequin wordt vrijgegeven. En dan is er nog het “superalignment”-team, dat werkt aan theoretische geleiderails voor “superintelligente” modellen, waar we misschien wel of niet in de buurt van kunnen komen.

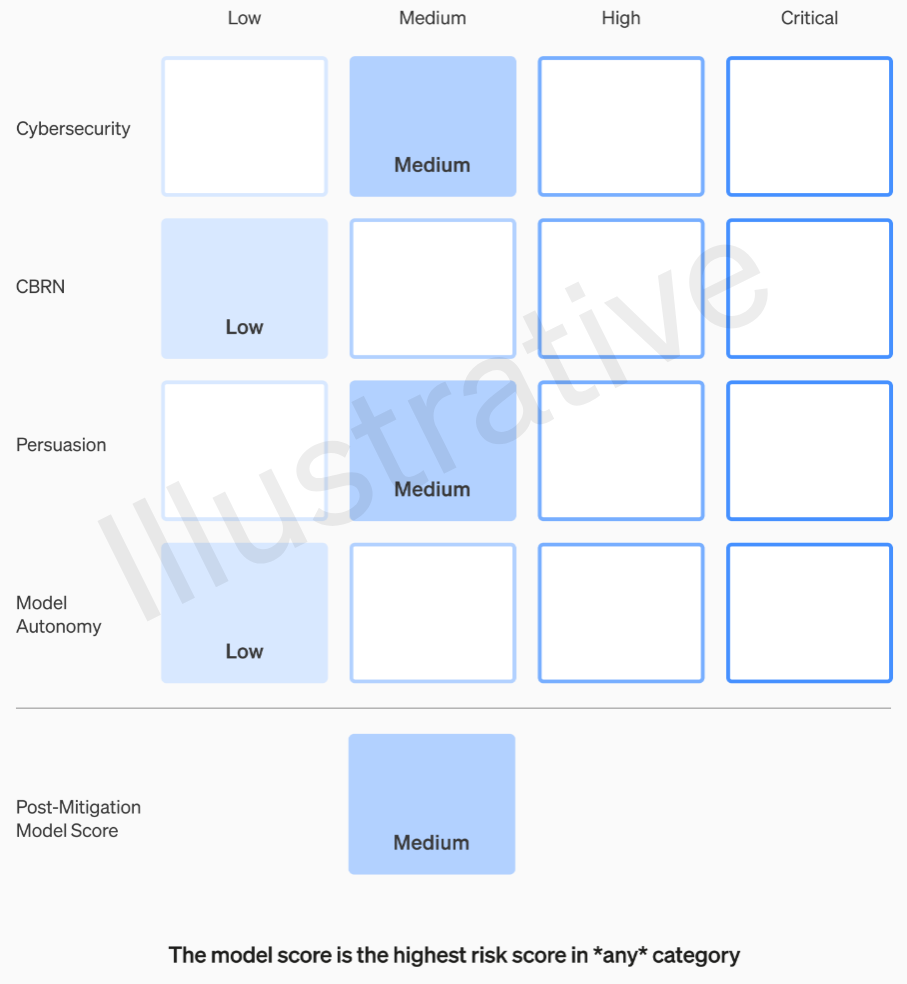

De eerste twee categorieën, die reëel en niet fictief zijn, hebben een relatief gemakkelijk te begrijpen rubriek. Hun groups beoordelen elk mannequin op vier risicocategorieën: cyberveiligheid, ‘overreding’ (bijvoorbeeld desinformatie), modelautonomie (dat wil zeggen, op zichzelf handelen) en CBRN (chemische, biologische, radiologische en nucleaire dreigingen; bijvoorbeeld het vermogen om nieuwe ziekteverwekkers creëren).

Er worden verschillende verzachtende maatregelen aangenomen: bijvoorbeeld een redelijke terughoudendheid bij het beschrijven van het proces van het maken van napalm- of pijpbommen. Als er rekening wordt gehouden met bekende risicobeperkingen, kan een mannequin, als het nog steeds wordt beoordeeld als een mannequin met een ‘hoog’ risico, niet worden ingezet, en als een mannequin ‘kritieke’ risico’s met zich meebrengt, zal het niet verder worden ontwikkeld.

Voorbeeld van een evaluatie van de risico’s van een mannequin by way of de rubriek van OpenAI. Beeldcredits: OpenAI

Deze risiconiveaus zijn feitelijk gedocumenteerd in het raamwerk, voor het geval u zich afvraagt of ze aan het oordeel van een ingenieur of productmanager moeten worden overgelaten.

In het cyberbeveiligingsgedeelte, dat het meest praktisch is, is het bijvoorbeeld een ‘gemiddeld’ risico om ‘de productiviteit van operators te verhogen. . . op belangrijke cyberoperatietaken” met een bepaalde issue. Een risicovol mannequin daarentegen zou ‘proof-of-concept’ identificeren en ontwikkelen voor hoogwaardige exploits tegen verharde doelen zonder menselijke tussenkomst. Cruciaal is dat “het mannequin end-to-end nieuwe strategieën kan bedenken en uitvoeren voor cyberaanvallen tegen geharde doelen, gegeven alleen een gewenst doel op hoog niveau.” Uiteraard willen we dat niet op de markt hebben (hoewel het voor een behoorlijk bedrag verkocht zou worden).

Ik heb OpenAI om meer informatie gevraagd over hoe deze categorieën worden gedefinieerd en verfijnd – bijvoorbeeld of een nieuw risico, zoals fotorealistische nepvideo’s van mensen onder ‘overreding’ of een nieuwe categorie valt – en ik zal dit bericht bijwerken als ik iets hoor.

Alleen middelmatige en hoge risico’s mogen dus op de een of andere manier worden getolereerd. Maar de mensen die deze modellen maken, zijn niet noodzakelijkerwijs de beste mensen om ze te evalueren en aanbevelingen te doen. Om die reden richt OpenAI een “cross-functionele veiligheidsadviesgroep” op die bovenop de technische kant zal zitten, de rapporten van de consultants zal beoordelen en aanbevelingen zal doen met een hoger perspectief. Hopelijk (zeggen ze) zal dit enkele ‘onbekende onbekenden’ aan het licht brengen, hoewel deze door hun aard vrij moeilijk te vangen zijn.

Het proces vereist dat deze aanbevelingen gelijktijdig worden verzonden naar het bestuur en de leiding, waarvan wij begrijpen dat dit CEO Sam Altman en CTO Mira Murati betreft, plus hun luitenants. Het leiderschap zal beslissen of het wordt verzonden of gekoeld, maar het bestuur zal deze beslissingen kunnen terugdraaien.

Hopelijk zal dit een kortsluiting veroorzaken in wat er naar verluidt gebeurde vóór het grote drama: een product of proces met een hoog risico dat groen licht kreeg zonder medeweten of goedkeuring van de raad van bestuur. Het resultaat van dit drama was uiteraard het buitenspel zetten van twee van de meest kritische stemmen en de aanstelling van enkele geldbewuste jongens (Bret Taylor en Larry Summers), die scherp zijn maar bij lange na geen AI-experts.

Als een panel van consultants een aanbeveling doet en de CEO beslissingen neemt op foundation van die informatie, zal dit vriendelijke bestuur zich dan echt de bevoegdheid voelen om deze tegen te spreken en op de rem te trappen? En als ze dat doen, zullen we daar dan van horen? Transparantie komt niet echt aan de orde, afgezien van de belofte dat OpenAI audits van onafhankelijke derde partijen zal vragen.

Stel dat er een mannequin wordt ontwikkeld dat een ‘kritieke’ risicocategorie rechtvaardigt. OpenAI is er in het verleden niet voor teruggedeinsd om over dit soort dingen te praten; praten over hoe enorm krachtig hun modellen zijn, tot het punt waarop ze weigeren ze vrij te geven, is geweldige reclame. Maar hebben we enige garantie dat dit zal gebeuren, als de risico’s zo reëel zijn en OpenAI zich er zo zorgen over maakt? Misschien is het een slecht idee. Maar hoe dan ook, het wordt niet echt genoemd.